🚀 Sabes cómo elegir entre Snowflake, Databricks, Fabric, AWS, Google Cloud, Open Source... como Plataforma de Datos? 𝗢𝘀 𝗰𝗼𝗺𝗽𝗮𝗿𝘁𝗼 𝗲𝗹 '𝗰𝗵𝗲𝗰𝗸𝗹𝗶𝘀𝘁' 𝗾𝘂𝗲 𝘂𝘁𝗶𝗹𝗶𝘇𝗼, para no dejaros ningún detalle importante fuera

Descargar imagen de calidad: https://todobi.com/content/files/2025/12/Moderna-Arquitectura-de-Datos06_peq-oscuro.png

🧱 𝗜𝗻𝗳𝗿𝗮𝗲𝘀𝘁𝗿𝘂𝗰𝘁𝘂𝗿𝗮 𝘆 𝗽𝗹𝗮𝘁𝗮𝗳𝗼𝗿𝗺𝗮

1. Compatibilidad multi-nube y on-premise ¿Soporta AWS, Azure, GCP y entornos

Leer más...

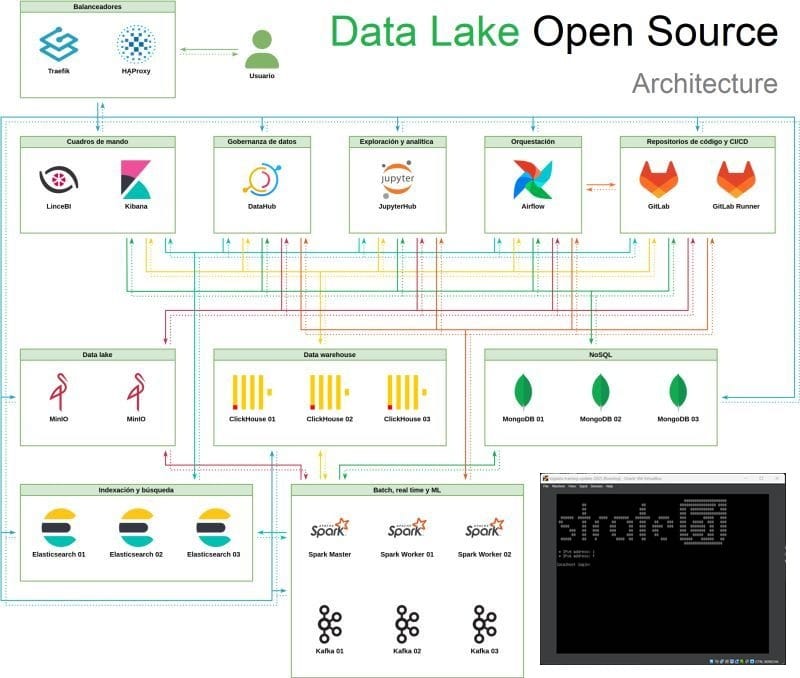

🚀 Anuncio: ya está disponible la 𝗽𝗹𝗮𝘁𝗮𝗳𝗼𝗿𝗺𝗮 𝗗𝗮𝘁𝗮 𝗟𝗮𝗸𝗲 𝗢𝗽𝗲𝗻 𝗦𝗼𝘂𝗿𝗰𝗲, 𝗾𝘂𝗲 𝗶𝗻𝗰𝗹𝘂𝘆𝗲 𝗜𝗔 para consultas analíticas

🔎 Al estilo de Cortex AI de Snowflake, esta solución basada en Open Source trabaja con ‘text to sql’. LinceBI

La arqutectura se divide en App Frontend, Core de IA y capa de datos, desacopladas mediante APIs REST sobre FastAPI.

- El frontend

Leer más...

🚀 Me podréis llamar 'pesado', pero para crear completas y complejas Arquitecturas de Datos en Producción, incluso en la 'Era AI' y 'Cloud Native', hay que tener muy claros los conceptos fundamentales

Veo a menudo, tanto en 'roles analíticos de entrada', como en

Leer más...

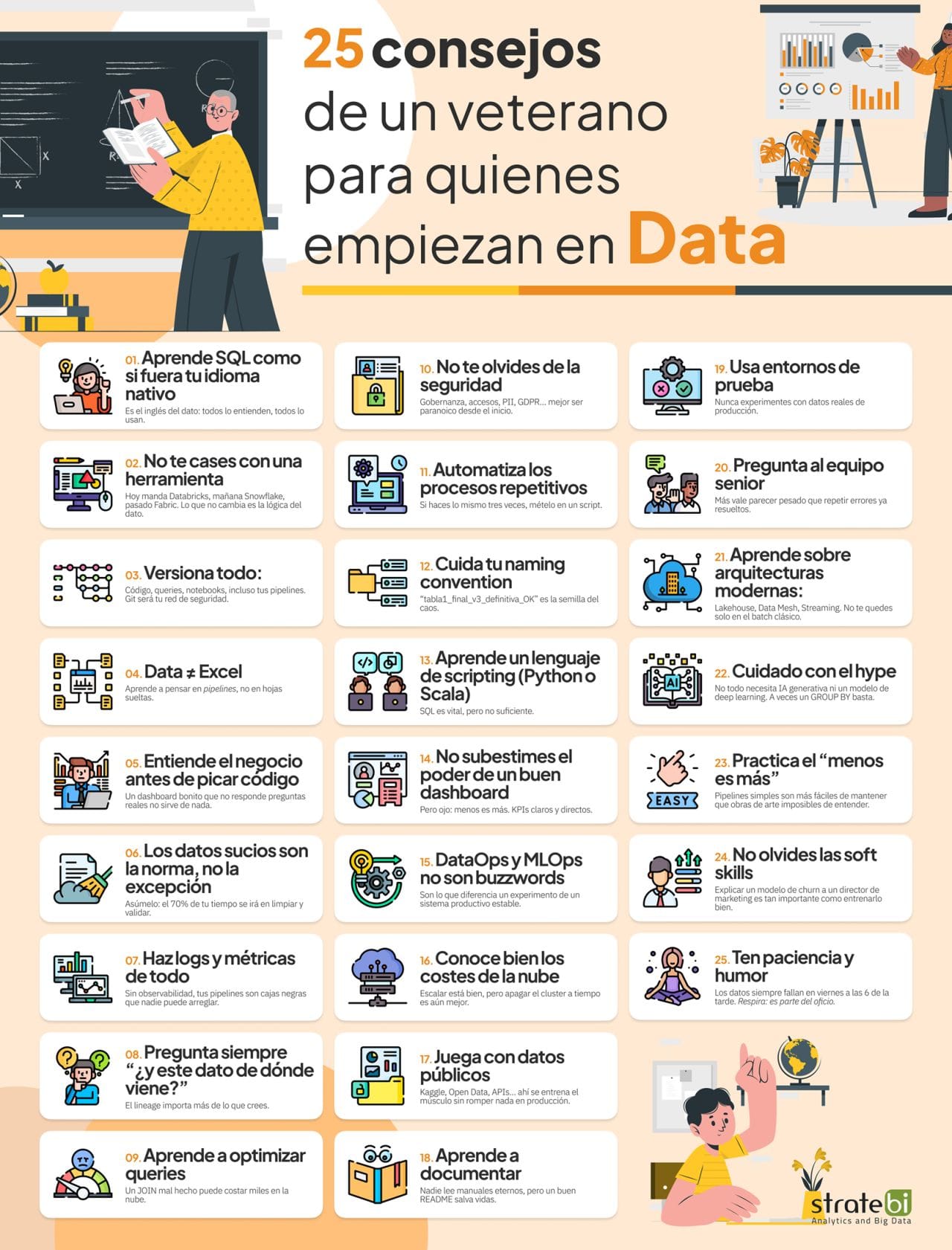

🚀 Quieres empezar o progresar en el mundo Data pero no sabes cómo?Un veterano del sector, el que os escribe, 😀, os comparte 𝟮𝟱 𝗰𝗼𝗻𝘀𝗲𝗷𝗼𝘀 𝗲𝗻 𝗗𝗮𝘁𝗮 que ojalá hubiera conocido al principio

🔎 Uso siempre esta lista en mis charlas, cursos, 'onboarding' de nuevos compañeros, kickoff de proyectos... Espero que os sea útil!

Leer más...

🚀 La mejor forma de aprender es tocando código!! Conoce el 𝗕𝗶𝗴 𝗗𝗮𝘁𝗮 𝗘𝗻𝗴𝗶𝗻𝗲𝗲𝗿 𝗦𝗮𝗻𝗱𝗯𝗼𝘅

Esta plataforma de formación práctica en big data, analítica avanzada y arquitectura de datos, útil tanto para equipos internos como para formación a clientes, partners. La plataforma se apoya en una máquina virtual (VM) autoconfigurable, que integra las tecnologías más

Leer más...

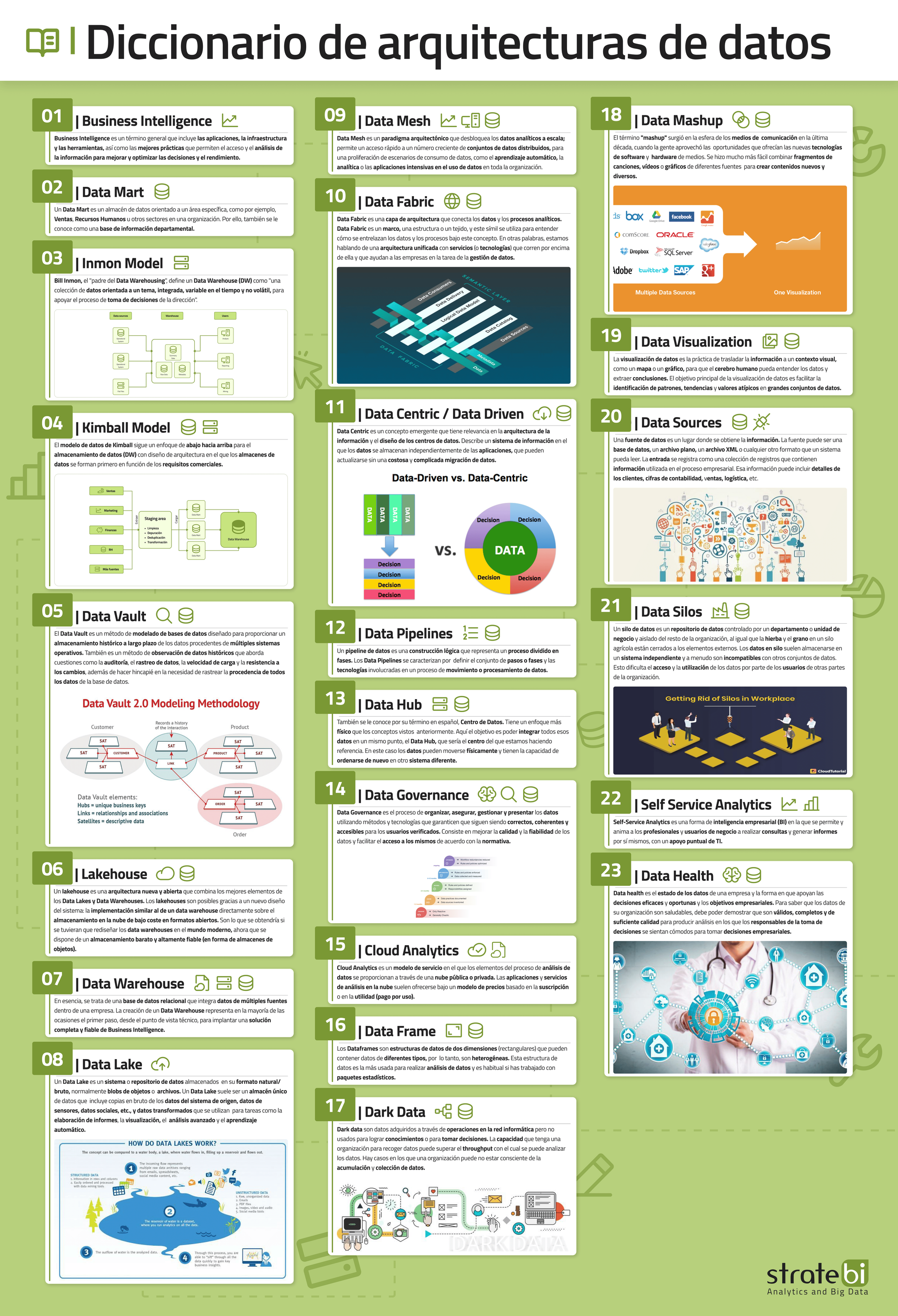

🚀 Tras muchos años trabajando con datos y si te interesa este mundo, 𝘁𝗲 𝗰𝗼𝗺𝗽𝗮𝗿𝘁𝗼 𝗹𝗮𝘀 𝗽𝗿𝗶𝗻𝗰𝗶𝗽𝗮𝗹𝗲𝘀 𝗔𝗿𝗾𝘂𝗶𝘁𝗲𝗰𝘁𝘂𝗿𝗮𝘀 𝗱𝗲 𝗗𝗮𝘁𝗼𝘀 𝗲𝘅𝗽𝗹𝗶𝗰𝗮𝗱𝗮𝘀!! (He creado una infografía y un paper detallado)

🔎 Descargar Diccionario de Datos: https://lnkd.in/dPCQx5dz

🔎 Descargar Infografía en imagen de calidad: https://lnkd.in/d_Z5a7Ci

📚 Os comparto un diccionario visual imprescindible con 23 conceptos clave de

Leer más...

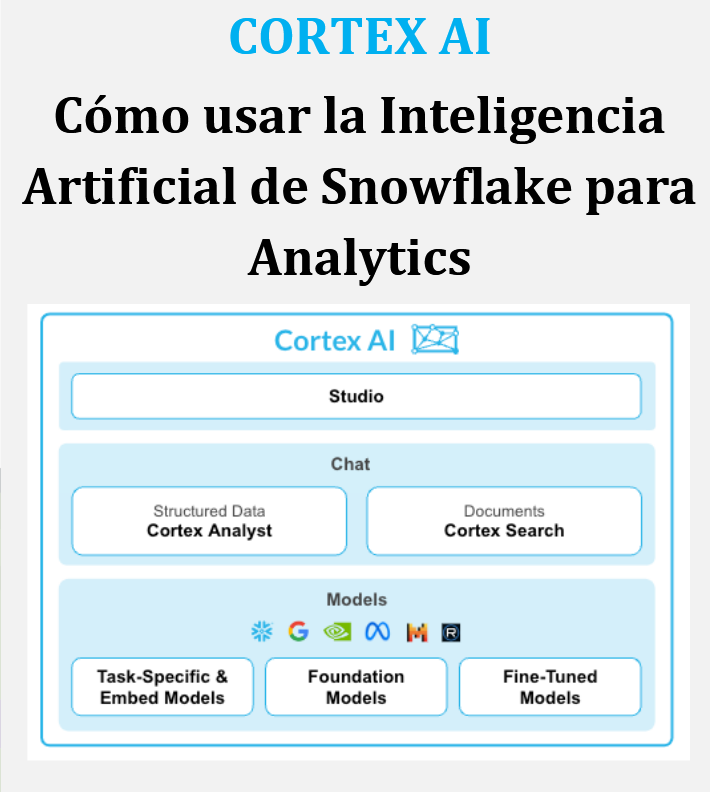

🚀 Snowflake lanza Cortex Analyst AI: así cambia para siempre como 𝗵𝗮𝗰𝗲𝗺𝗼𝘀 𝗮𝗻𝗮́𝗹𝗶𝘀𝗶𝘀 𝗱𝗲 𝗱𝗮𝘁𝗼𝘀 𝗰𝗼𝗻 𝗲𝗹 𝘂𝘀𝗼 𝗱𝗲 𝗹𝗮 𝗜𝗻𝘁𝗲𝗹𝗶𝗴𝗲𝗻𝗰𝗶𝗮 𝗔𝗿𝘁𝗶𝗳𝗶𝗰𝗶𝗮𝗹. 'Text to SQL' y mucho más. Os comparto un paper técnico detallado (23 págs.)!!

💬 Este es uno de los sueños de los que llevamos mucho tiempo dedicándonos a Business Intelligence, Data Warehouse y Analytics. Os incluyo ejemplos reales,

Leer más...

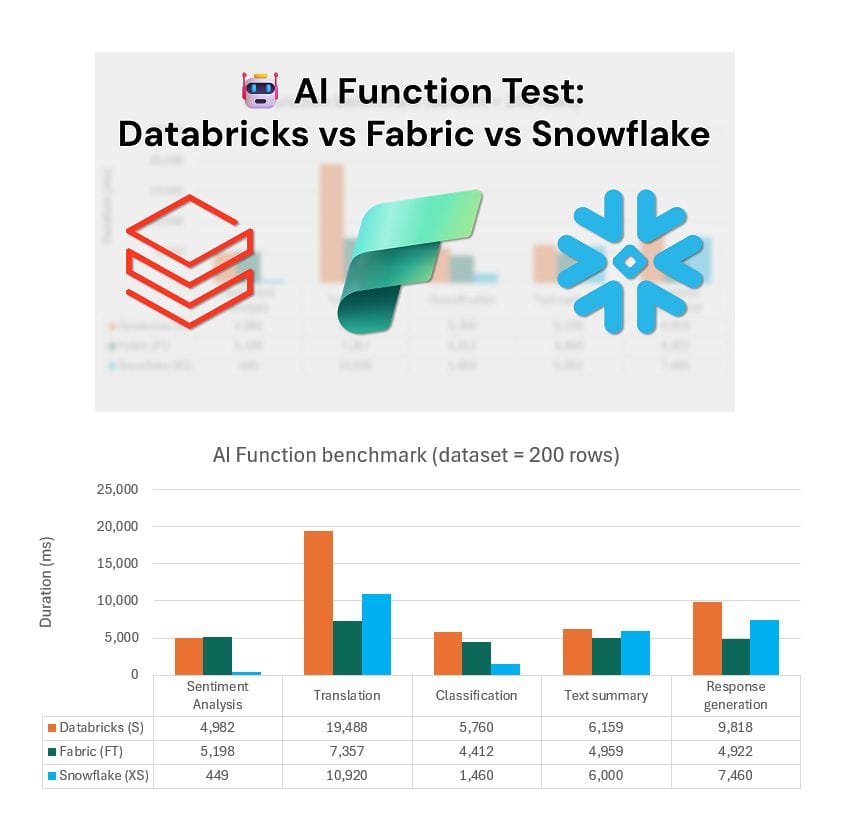

🚀 Que plataforma de Datos (𝗙𝗮𝗯𝗿𝗶𝗰, 𝗦𝗻𝗼𝘄𝗳𝗹𝗮𝗸𝗲, 𝗗𝗮𝘁𝗮𝗯𝗿𝗶𝗰𝗸𝘀), trabaja mejor con funciones AI (Inteligencia Artificial)?

Este benchmark de Pawel Potasinski es de gran utilidad

🔎 Lo primero es entender como trabaja cada plataforma para entender los resultados:

𝗗𝗮𝘁𝗮𝗯𝗿𝗶𝗰𝗸𝘀. Las funciones de IA son funciones integradas que se utilizan para aplicar IA, como la traducción de texto

Leer más...

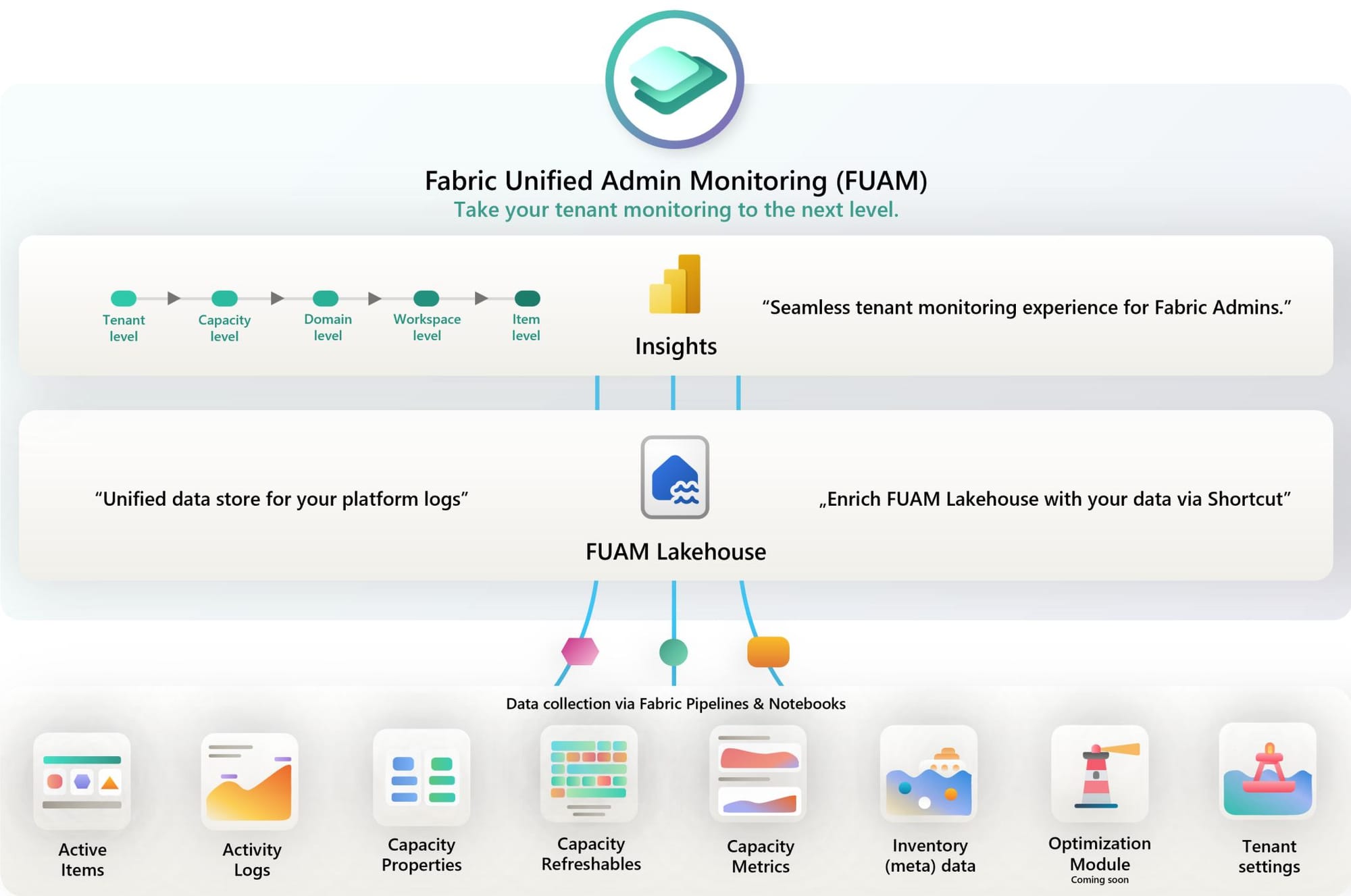

🚀 Todo lo nuevo que se está 𝗹𝗮𝗻𝘇𝗮𝗻𝗱𝗼 𝘀𝗼𝗯𝗿𝗲 𝗠𝗶𝗰𝗿𝗼𝘀𝗼𝗳𝘁 𝗙𝗮𝗯𝗿𝗶𝗰 es increible. Ahora llega FUAM dentro de 𝗙𝗮𝗯𝗿𝗶𝗰 𝗧𝗼𝗼𝗹𝗯𝗼𝘅, como código abierto

🔎 𝗤𝘂𝗲 𝗲𝘀 𝗙𝗮𝗯𝗿𝗶𝗰 𝗧𝗼𝗼𝗹𝗯𝗼𝘅? https://lnkd.in/dy5K8hp8Fabric toolbox es un repositorio de herramientas, aceleradores, scripts y ejemplos para ayudarte a trabajar con Microsoft Fabric. Este repositorio ha sido creado por el Fabric Customer Advisory Team (CAT) y

Leer más...