Hoy se ha anunciado que Pentaho abre a la comunidad Open Source las capacidades Big Data de sus herramientas, tomando la delantera en la disponibilidad gratuita frente al resto de ofertas del mercado.

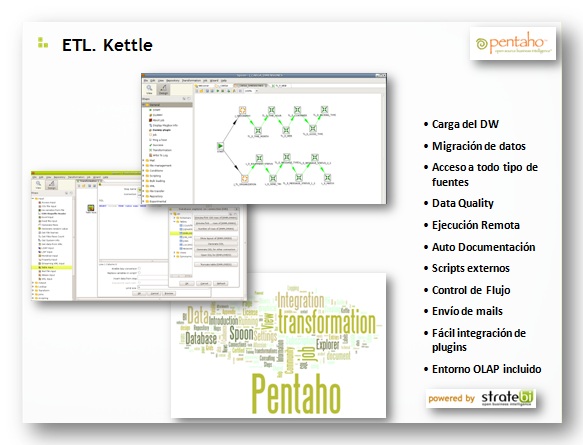

Pentaho , lo que realmente ha anunciado es que abre al Open Source las funcionalidades Big Data de su motor ETL (Kettle o Pentaho Data Integration ), una de las joyas de de Pentaho, y de la que siempre os recomendamos su uso. La licencia de Kettle pasa de LGPL a Apache License V2.0

Realmente nos alegramos de ello, pues en Stratebi , muchas empresas habían preguntado por estas funcionalidades.

Hitos principales del anuncio:

- Disponible la web para todos los aportes de la comunidad open source sobre Pentaho Big Data.

- Lo que nos va a permitir es que con el uso de Kettle, vamos a poder tener capacidades, mediante 'steps' de entrada, salida, manipular los datos y generar informes con los siguientes entornos: Hadoop y almacenamientos NoSQL : Cassandra, Hadoop HDFS, Hadoop MapReduce, Hadapt, HBase, Hive, HPCC Systems y MongoDB.

- Las principales distribuciones de Hadoop están soportadas, incluyendo: Amazon Elastic MapReduce, Apache Hadoop, Cloudera’s Distribution including Apache Hadoop (CDH), Cloudera Enterprise, EMC Greenplum HD, HortonWorks Data Platform powered by Apache Hadoop, yMapR’s M3 Free y M5 Edition.

- Kettle puede ejecutarse tanto dentro como fuera del cluster de Hadoop

Ventajas para usuarios y desarrolladores:

- Delivers at least a 10x boost in productivity for developers through visual tools that eliminate the need to write code such as Hadoop MapReduce Java programs, Pig scripts, Hive queries, or NoSQL database queries and scripts;

- Makes big data platforms usable for a huge breadth of developers, whereas previously big data platforms were usable only by the geekiest of geeks with deep developer skills such as the ability write Java MapReduce jobs and Pig scripts;

- Enables easy visual orchestration of big data tasks such as Hadoop MapReduce jobs, Pentaho MapReduce jobs, Pig scripts, Hive queries, HBase queries, as well as traditional IT tasks such as data mart/warehouse loads and operational data extract-transform-load jobs;

- Leverages the full capabilities of each big data platform through Pentaho Kettle’s native integration with each one, while enabling easy co-existence and migration between big data platforms and traditional relational databases;

- Provides a super-easy on-ramp to the full data discovery and visualization capabilities of Pentaho Business Analytics, including reporting, dashboards, interactive data analysis, data mining and predictive analysis.

Significa que ahora se puede usar Kettle para integrar una gran variedad de tecnologías , que van desde archivos, bases de datos relacionales , Big Data y NoSQL . Se puede hacer sin necesidad de escribir ningún código. Ver el ejemplo de Matt Casters, creador de Kettle, que estuvo con nosotros en Madrid , como se programa para Hadoop MapReduce .

Donde descargo y consigo más informacion:

- Wiki-Web de Pentaho Big Data

- About Kettle and Big Data

- Pentaho Big Data Plugin

- SVN Repository: svn://source.pentaho.org/svnkettleroot/pentaho-big-data-plugin

- CI: pentaho-big-data-plugin

- Download the latest development build: pentaho-big-data-plugin-TRUNK-SNAPSHOT.tar.gz

- Big Data Forum

- Documentacion

Kettle Plugin Development

Getting started with the Pentaho Data Integration Java API